Les liens entre l’intelligence artificielle et le seo vous intéressent ? Si vous avez un peu de temps, lisez cet article. Il va vous apporter des éléments de réflexion. Vous serez étonné de voir que le concept ancien de la loi des rendements décroissants est d’actualité pour le SEO.

Ce concept, initialement développé dans la sphère économique, aide à comprendre certains biais actuellement rencontrés par les utilisateurs de l’IA. Le domaine de la création de contenu assistée par les IA génératives est ce qui m’intéresse ici. Je m’interroge en particulier sur le rapport entre les gains de productivité obtenus et les émissions de carbone qu’ils génèrent.

Avant de passer aux explications, permettez-moi une remarque. L’expression référencement naturel m’a toujours frappé. Pourquoi qualifier de naturel un processus ultra technique ? Dans mon exploration des liens entre la loi des rendements décroissants, l’IA et le SEO, j’ose un parallèle avec l’agriculture qui peut aider à comprendre.

Histoire et définition de la loi des rendements décroissants

Afin de bien démarrer la réflexion, déployer une partie sur l’histoire et la définition de la loi des rendements décroissants est nécessaire. Ce petit détour vous aidera, j’en suis sûr, surtout si vous ne savez pas de quoi il s’agit ou découvrez le concept.

Histoire de la loi des rendements décroissants

La loi des rendements décroissants est une théorie économique qui s’applique lorsque l’ajout d’une ressource supplémentaire n’accroît pas de façon proportionnelle la production. Historiquement liée à l’économie, cette loi a été inventée au début du XIXe siècle dans l’agriculture et l’industrie.Thomas Malthus en a posé les bases. Il s’était intéressé à la relation entre la production agricole et la croissance de la population. David Ricardo a formalisé l’idée, en l’intégrant dans la théorie économique. Il s’en est servi pour analyser la répartition des revenus entre les propriétaires terriens, les travailleurs et les capitalistes. La théorie des rendements décroissants est un pilier de l’économie classique et continue d’influencer les théories économiques modernes. Marx s’est, entre autres, appuyé sur ce concept pour critiquer le capitalisme. Pour lui, la loi des rendements décroissants illustre les contradictions internes du système.

La loi des rendements décroissants dans l’agriculture

Prenons l’exemple agricole, choisi justement parce que le terme référencement naturel m’y fait penser. La loi des rendements décroissants s’applique au domaine des engrais et de la baisse de fertilité des terres de la manière suivante :

- À court terme, les engrais augmentent significativement les rendements agricoles. Ils fournissent aux plantes les nutriments dont elles ont besoin pour pousser et produire des fruits ou des légumes. En augmentant la quantité d’engrais, les agriculteurs accroissent la quantité de nourriture produite sur une parcelle de terre donnée.

- À long terme, l’application excessive d’engrais peut entraîner une baisse de la fertilité des terres. Les engrais polluent les sols et les rendent moins capables de retenir les nutriments. Ils peuvent également acidifier les sols, nécessitant l’apport d’éléments régulateurs.

En clair, l’augmentation d’une quantité d’engrais X ne produit pas une augmentation proportionnelle des rendements agricoles. À mesure que la quantité d’engrais augmente, l’augmentation des rendements agricoles diminue. Autrement dit, le temps long joue en défaveur des cultures optimisées par les engrais. Pour maintenir le même niveau de production, il est nécessaire d’augmenter la quantité d’engrais.

Histoire de l’intelligence artificielle et ses rapports avec les rendements décroissants

Le raisonnement précédent peut nous aider à comprendre ce qui se passe du côté de l’intelligence artificielle et du SEO. Toutefois, pour mieux suivre la logique, retenez que je considère l’engrais comme un outil d’optimisation. L’engrais est à l’agriculture ce que l’IA générative est au SEO. Pour avancer dans l’appréhension du phénomène, il faut à nouveau faire un petit détour historique et théorique, mais cette fois, au pays de l’IA.

Histoire de l’IA et des réseaux de neurones

C’est à la fin des années 50 que les concepts de réseaux neuronaux à base d’ordinateurs font leur apparition. L’ambition d’un psychologue, Frank Rosenblatt de Cornell, est de fabriquer un réseau neuronal artificiel, un “dispositif de reconnaissance de formes”. Mais il doit très vite revoir son ambition, son perceptron (un ordinateur IBM 704) n’est pas assez puissant pour les calculs que la reconnaissance de formes exige. Il faudra attendre les ordinateurs de l’an 2000 pour que son concept puisse s’appliquer correctement.

Aujourd’hui, les chercheurs et scientifiques en IA, et plus spécifiquement en deep learning, se rapprochent de la limite calculatoire, comme l’a subi en son temps Rosenblatt. Le problème provient de la méthode “d’apprentissage”, nommée descente de gradient stochastique.

Pour faire simple, et les spécialistes de l’IA me pardonneront, cette méthode suppose de disposer de plus de paramètres que données disponibles pour l’apprentissage. Le deep learning relève de la statistique et de l’analyse d’un grand modèle de données. C’est d’ailleurs pour cela qu’on appelle LLM (Large Langage Models) les IA génératives.

Prenons l’exemple du système de reconnaissance d’images de pointe Noisy Student. Il est basé sur le deep learning. Pour reconnaître une image sur l’analyse des pixels, il exploite un réseau de 480 millions de paramètres. Ces paramètres sont issus de seulement 1,2 million d’images étiquetées (les données d’apprentissage). Pour que l’IA fonctionne, les ingénieurs ont dû construire un dataset 400 fois plus grand que celui constitué par les données de départ, les images étiquetées.

L’apprentissage profond : un goinfre énergétique

Très flexibles, les modèles d’apprentissage profond entraînent cependant un coût énergétique de calcul énorme. C’est leur talon d’Achille. Des chercheurs ont réalisé des extrapolations, en tenant compte des progrès de reconnaissance d’objets par l’IA des dernières années. Ils en concluent qu’il est possible d’imaginer qu’en 2025, le taux d’erreur serait réduit à 5 %. Cependant, obtenir ce gain marginal entraînerait l’émission d’autant de CO₂ que ce que génère New York en un mois.

À ce niveau du raisonnement, plusieurs éléments sont à noter :

Pour améliorer les performances de l’IA d’un facteur k, il faut k² de données supplémentaires pour l’entraîner. Répercuté sur le coût, les consommations énergétiques et donc les émissions de CO₂ s’élèvent à k⁴. Pour faire 10 fois mieux, ça coûte 10 000 fois plus d’énergie. D’autres études ont démontré que pour réduire de moitié le taux d’erreur, il faut 500 fois plus de ressources de calcul. Ainsi, pour atteindre un taux d’erreur de 5 %, il faut 10,19 milliards d’opérations en virgule flottante. Pour faire simple, la science a réglé les limites techniques du perceptron, mais a créé un problème énergétique.

La limite de la consommation énergétique

Il n’est pas difficile de comprendre que, pour le moment, atteindre des taux d’erreur de 5 % semble difficilement envisageable si l’on veut limiter les émissions de carbone. C’est encore plus vrai si l’on vise 1 %.

D’une façon générale, la problématique de l’IA se pose de la manière suivante :

- trouver des solutions technologiques moins énergivores ;

- revoir les ambitions du progrès en attendant de nouvelles découvertes.

Voyons du côté des acteurs. Open AI communique peu sur les chiffres. Pour autant, on sait que les ingénieurs ont commis une erreur dans la mise en œuvre de GPT-3. Ils ont expliqué qu’à cause du coût de la formation du système, il leur était impossible de le recycler (= le reprogrammer). De grandes firmes américaines se seraient d’ores et déjà détournées de l’utilisation du deep learning pour des raisons de coût énergétique.

Les deux stratégies de la communauté du deep learning : la spécialisation et la miniaturisation

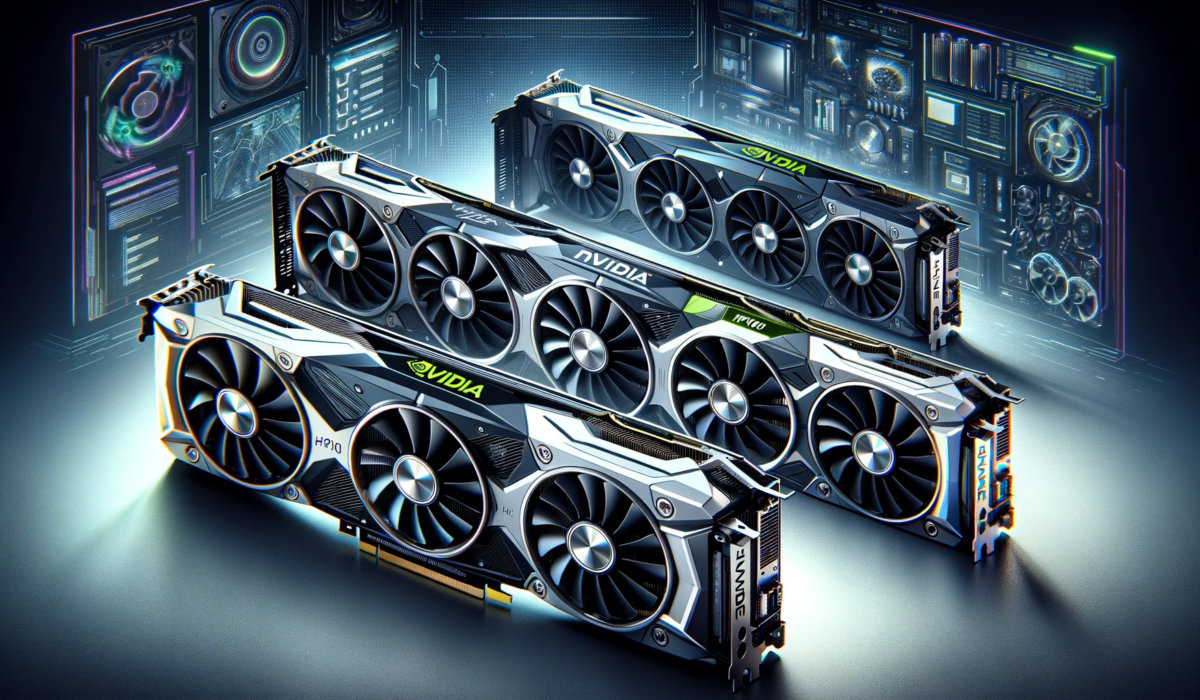

Face à ces défis, les stars de l’IA et du deep learning ne restent pas les bras croisés. La première option, actuellement utilisée, est de remplacer les processeurs (ADN généraliste) par les GPU (= processeur spécialisé et optimisé pour le traitement parallèle de nombreuses tâches similaires). La stratégie est de sacrifier l’approche généraliste pour une stratégie de spécialisation.

C’est là que le concept de rendement décroissant apparaît. Pour garantir des gains à long terme, le système devra adopter des cadres matériels différents, générant des coûts supplémentaires élevés.

La seconde tactique consiste à diminuer la taille des réseaux de neurones. Il semblerait que ce soit le choix de Google. Cependant, cela augmente le coût de leur formation/apprentissage.

La solution des experts humains

D’autres stratégies sont actuellement en développement pour contourner les limites posées par l’inflation du coût énergétique de l’IA d’apprentissage profond. Il s’agit par exemple du méta-apprentissage d’images (Andrei Bardu, du MIT). L’idée est de faire apprendre le système sur un ensemble X de données, pour l’utiliser sur d’autres données. Mais des variations minimes sur les données d’entrée font augmenter le taux d’erreur. Ces variations peuvent être, par exemple, l’angle de la prise de vue, la lumière, etc.). Des recherches sont en cours sur des méthodes neuro-symboliques (intégrer une représentation et un raisonnement des connaissances bien fondés). La méthode de l’élagage est une autre piste. Elles peuvent réduire le nombre de paramètres des réseaux de plus de 90 %. Ce faisant, les besoins de stockage sont moindres, les performances de calcul sont maintenues et la précision est identique.

En attendant, il s’avère que l’utilisation d’experts humains qui sélectionnent les données d’apprentissage soit la manière la plus économe de faire fonctionner le deep learning. Cette méthode réduit les performances de ces modèles. Mais c’est actuellement une piste qui semble couramment utilisée. Par exemple, les systèmes experts en radiologie et oncologie utilisent des variables prédéfinies par des spécialistes pour une analyse efficace avec moins de calculs.

Les rendements décroissants, l’intelligence artificielle et le SEO : c’est lié ?

Il ressort de ce qui est dit précédemment que les modèles de deep learning consomment beaucoup trop d’énergie. S’ajoute à ce problème qu’ils visent à réduire leur taux d’erreur, ce qui accroît encore un peu plus la consommation énergétique. Dans le domaine de la génération de contenu, cet effort permet de diminuer le taux “ d’hallucinations”. Sur le principe, je pense que tout le monde est d’accord.

Toutefois, la puissance de calcul supplémentaire nécessaire pour atteindre cette perfection augmente de façon exponentielle. C’est ce “dernier kilomètre” qui a un coût énergétique extrêmement élevé pour la société et la planète. C’est cette étape ultime qui illustre parfaitement, à mon sens, la loi des rendements décroissants en IA. Mais voyons plus en détail les rapports entre l’IA et le SE, pour mettre en lumière les liens avec les rendements décroissants.

L’intelligence artificielle en SEO utilise des GPU

Les modèles que vous utilisez pour générer vos contenus, comme BARD ou CHATGPT utilisent des ressources matérielles. Cette partie hardware fait l’objet d’une course à l’innovation sans merci. Les parties prenantes ont pour objectif d’accélérer les vitesses de traitement (donc de réponse), d’affiner le fonctionnement, de réduire le taux d’erreur et de réduire la consommation énergétique. Voici un tableau comparatif des deux grandes puces utilisées dans les architectures informatiques des LLM.

Critère | TPU v5 Google | H100 NVIDIA |

Année de création | 2022 | 2023 |

Puissance | 400 W | 700 W |

Capacité de calcul | 180 téraflops | 312 téraflops |

Processus de fabrication en nm | Fabriquée selon le processus de 7nm | Fabriqué avec le processus TSMC 4nm personnalisé pour NVIDIA |

Efficacité énergétique | 2x la performance d’entraînement par dollar et 2.5x la performance d’inférence par dollar par rapport à TPU v4 | Performances importantes pour l’IA et le HPC par rapport à A100 |

Modèles d’apprentissages utilisés | Large Language Models (LLM) et modèles d’IA génératifs BERT, LaMDA, PaLM | Utilisé pour des modèles Genomics, GPT-3, GPT-4, DLRM, etc. |

Quelle est la taille des LLM comme CHATGPT et BARD ?

Continuons d’avancer sur l’appréhension physique des outils que vous utilisez. Un maçon a besoin de connaître la taille de sa brouette ou de son camion. Découvrez ci-dessous l’essentiel de ce qu’il y a à savoir sur votre matériel professionnel, dans un nouveau tableau comparatif. Attention, les informations sont à prendre avec du recul, les firmes ne communiquent pas ou peu sur des données aussi sensibles.

Caractéristiques | BARD | CHAT GPT3 | CHAT GPT4 |

Nombre de paramètres d’entraînement | 137 milliards | 175 milliards | 1,56 trillion |

Nombre de GPU utilisés | 1000 | 16000 | 16000 |

Lieu d’implantation des systèmes | Google Cloud Platform | OpenAI | OpenAI |

Implantation géographique | 20 pays dont Amérique du Nord, du Sud, Europe. | États-Unis (Fremont, Californie) | États-Unis (Fremont, Californie) |

Ces deux tableaux illustrent les progrès technologiques réalisés ces dernières années, depuis la puce TPU v4 ou la A100. Mais, pour illustrer l’aspect énergétique, la puce H100 (alias Hopper) est plus puissante que la A100 (700 W contre 400 W).

Guerre médiatique et course à l’efficacité énergétique

En faisant une revue de presse, on s’aperçoit également que la guerre médiatique fait rage entre les firmes. Ainsi, l’article sur l’intelligence artificielle du site Tom’sguide rapporte que, déjà avant l’apparition des nouvelles puces, les chercheurs de Google affirmaient que “ la puce TPU v4 est “1,2x-1,7x plus rapide et utilise 1,3x-1,9x moins d’énergie que le Nvidia A100 “.

Le PDG de Nvidia, Jensen Huang s’est exprimé dans la conférence GTC NVIDIA keynote 2023. Il indique que les résultats de Hopper sont : “quatre fois plus performants que A100“. Il dit également que “le prochain niveau d’IA générative nécessite une nouvelle infrastructure d’IA pour former de grands modèles de langage avec une grande efficacité énergétique.”

Les commentaires des scientifiques appartenant à la recherche publique sur ces stratégies de communication des firmes sont nombreux. L’un d’eux, Pierre Aubert, du Laboratoire d’Annecy de Physique des Particules, propose un retour sur la conférence Keynote NVIDIA 2023. Il indique qu’il est possible de réduire la consommation énergétique des GPU en réduisant la fréquence de calcul. Il fournit un chiffre : réduire la fréquence de calcul de 20 % réduit de 25 % la consommation énergétique.

L’efficacité énergétique au cœur des innovations

Penchez-vous, si le sujet vous intéresse, sur les publications de NVIDIA et sa politique de communication concernant l’efficacité énergétique. Vous vous rendrez-compte que c’est un sujet majeur. Elle est tellement travaillée qu’elle illustre le fait que la firme a compris que l’acceptabilité sociétale de l’IA conditionne ses futurs développements.

On peut, par exemple, y lire que les utilisations croissantes des intelligences artificielles vont faire exploser la demande énergétique, et donc les émissions de gaz à effets de serre. La firme souligne : “ c’est un problème qui doit être géré”. C’est, pour moi, le signe que les acteurs majeurs ont conscience que la loi des rendements décroissants s’applique à l’IA. Le gain marginal d’efficacité a un coût énergétique élevé qui constitue un problème social.

Elle a mis par exemple sur pied des plateformes de supercalcul accéléré pour que les chercheurs de tous horizons réalisent davantage de travaux scientifiques par unité de temps tout en réalisant des économies d’énergie. S’agit-il d’une opération de séduction, d’une stratégie de captation de données ou d’un acte sociétal ?

Dans sa présentation, on peut lire “ En exécutant une sélection de quatre applications clés […] sur un serveur accéléré par quatre GPU NVIDIA A100 Tensor Core, le Centre National de Recherche Scientifique en Énergie Informatique (NERSC) observe une accélération des performances de 12X par rapport à un serveur bi-socket x86. À parité de performance, un cluster accéléré par GPU consomme 588 MWh d’énergie de moins par mois par rapport à un système uniquement CPU. Si un chercheur exécutait la même charge de travail à la même vitesse sur une instance cloud NVIDIA A100 à quatre voies pendant un mois, il économiserait 4 millions de dollars par rapport à une instance uniquement CPU”.

Faites-vous votre propre avis, consultez à vos heures perdues les ressources suivantes :

- optimisation énergétique des simulations informatiques ;

- définition de l’efficacité énergétique ;

- webinaire d’Alan Gray (ingénieur principal en technologie de développement) sur l’optimisation de l’efficacité énergétique des applications sur les GPU NVIDIA.

Les autres solutions pour réduire les consommations énergétiques de l’IA

L’état actuel de la connaissance est balbutiant sur ce sujet. Cependant, les scientifiques s’accordent à dire que bâtir une théorie est la première étape. Des tentatives s’appuient sur le phénomène de double descente.

Pour faire simple, il se décrit selon les étapes suivantes :

- augmenter la capacité du réseau entraîne un processus de surajustement ;

- il y a un seuil de paramètres – correspondant à celui des points de données, à partir duquel l’erreur tend vers l’infini ;

- en ajoutant de la capacité, l’erreur a tendance à se reproduire ;

- cependant, au fur et à mesure des ajouts de capacité, le taux d’erreur diminue en douceur.

Une théorie nouvelle permettra de savoir comment réaliser les mêmes calculs, avec la même précision, tout en consommant moins d’énergie. Mais l’état actuel de la science illustre que nous n’en sommes qu’à l’âge de la “force brute de l’intelligence artificielle”. Dans ce contexte, la loi des rendements décroissants en IA se situe au niveau de la consommation énergétique et des émissions de CO₂.

Qu’en est-il de la production de contenus en SEO avec l’intelligence artificielle ?

De nouvelles théories et solutions d’optimisation informatiques sont en train d’émerger. Le problème du surparamétrage des données reste un problème à régler. Ce modèle surparamétré était viable quand les IA étaient réservées aux scientifiques. Depuis qu’OPEN AI l’a popularisée et démocratisée, tout s’accélère. Les consommations d’énergies explosent. Mais revenons à nos moutons. Abordons maintenant les relations entre le SEO et l’IA, pour la partie production de contenus. Je vais tenter de faire un lien avec la loi des rendements décroissants.

Comment l’intelligence artificielle et le SEO interagissent dans la production de contenus web ?

L’intelligence artificielle générative est devenue un outil pertinent dans le domaine du SEO pour qui s’en sert de façon intelligente et raisonnée. On peut dire, sans trop se tromper, qu’elle révolutionne la façon de produire des contenus pour le web et qu’elle peut générer des gains de productivité.

Cette synergie entre intelligence artificielle et SEO commence dès la recherche d’idées pour le contenu. Un outil d’IA analyse les données du marché et les comportements des utilisateurs pour générer des sujets captivants et pertinents. Dans le processus de recherche documentaire, cette technologie facilite l’accès à des informations précises. Elle réduit considérablement le temps de travail consacré à cette étape de recherche.

L’IA aide également dans l’analyse des personas. C’est une étape clé pour le référencement efficace sur Google et d’autres moteurs de recherche. Selon le domaine, elle peut déchiffrer les préférences et les attentes des différents utilisateurs. Son utilisation contribue à accentuer la personnalisation du contenu, tout en sachant qu’elle ne remplace pas une vraie étude de terrain.

Dans la structuration et la rédaction de texte, l’IA opère également comme un guide. Elle peut proposer des plans intéressants, qui resteront bien sûr toujours à travailler.

Elle s’attaque efficacement au syndrome de la page blanche, stimulant la créativité et offrant des suggestions dès le début du processus de rédaction web. En revanche, il n’est absolument pas conseillé de l’utiliser pour trouver des mots clés ou connaître les volumes de fréquentation.

Intelligence artificielle et SEO : Comprendre les Rendements Décroissants

Dans le monde merveilleux du SEO, l’intelligence artificielle agit comme un puissant catalyseur. Pour rappeler notre métaphore initiale, l’IA est au SEO ce que l’engrais est à l’agriculture. Force est de constater qu’elle peut améliorer le processus de création de contenu pour le web. Cette synergie entre l’IA et le référencement web ouvre de nouvelles perspectives en matière d’optimisation de contenu. Cependant, il est essentiel de reconnaître que le recours excessif à ces outils peut conduire à la loi des rendements décroissants. C’est notamment le cas lorsque l’accent est mis davantage sur la quantité d’outils que sur leur qualité. Le SEO doit rester un savant équilibre de technique et d’humain.

Choix et Évaluation des Outils d'IA pour le SEO

Avec l’évolution constante de la technologie, le marché regorge d’outils d’IA dédiés au SEO. Des plugins aux applications, en passant par les API, le choix devient ardu. Des outils comme Atomic Content de Semji proposent, par exemple, la création de contenus branchée sur les outils SEO. Mais il n’en reste pas moins que sélectionner le bon outil nécessite une analyse approfondie. Chaque outil doit être évalué en fonction de sa capacité à améliorer le référencement sur Google et autres moteurs de recherche. Sa nouveauté, sa popularité, la qualité de son UX ne doivent pas être vos critères de choix.

Impact de la Surabondance d'Outils sur la Créativité et le Référencement

L’ajout systématique et indifférencié d’outils d’IA peut nuire à l’efficacité du référencement naturel. Le SEO est un art qui exige une compréhension fine des besoins des utilisateurs et une approche créative de la rédaction de contenu. Il suppose aussi des échanges avec l’éditeur de site ou le client.

Lorsque l’on privilégie la quantité d’outils d’IA à leur qualité, le travail de référencement peut réellement perdre en efficacité. Un outil supplémentaire ne garantit pas nécessairement une meilleure optimisation du contenu pour les moteurs de recherche. Cela peut même entraver la créativité nécessaire à la production de textes qui donnent envie aux utilisateurs de s’engager.

Rôle Prépondérant de l'IA dans l'Analyse des Données

Avec un peu d’expérience avec les outils d’IA, les rédacteurs et experts SEO ont plus de recul. Ils s’aperçoivent notamment que la valeur ajoutée principale de l’IA dans le domaine du SEO se situe à un point précis. Elle se manifeste dans l’analyse des données en amont de la production de contenu.

Avant même de commencer la rédaction, l’IA peut trier et analyser les données pour déterminer les sujets pertinents. Cette étape est cruciale pour s’assurer que le contenu produit répondra aux exigences des moteurs de recherche et aux attentes des utilisateurs. De cette façon, l’expert SEO construit une stratégie de marketing de contenu efficace.

Utilisation Judicieuse de l'IA pour Éviter la Redondance

Placée au mauvais endroit du processus de production, l’IA peut être un vrai désastre. L’usage excessif de l’IA conduit à produire un contenu répétitif et peu inspiré. Les algorithmes d’IA sont, c’est vrai, efficaces dans l’analyse statistique des données. Lorsqu’elles sont génératives, rappelons qu’elles ne font que prédire le mot suivant selon des probabilités.

Ces algorithmes perdent en efficacité lorsqu’ils sont utilisés pour retravailler constamment des textes. La loi des rendements décroissants s’illustre alors parfaitement. Plus on les utilise, moins la productivité s’accroît. Plus on en met, moins c’est bien. Cela aboutit à l’effet inverse. L’IA se perd, mélange, oublie les consignes et le texte glisse sur une pente douce de réduction de la qualité. L’originalité et la personnalisation, essentielles pour toucher les utilisateurs et améliorer le référencement naturel, se diluent.

Intelligence artificielle et SEO : Stratégie Hybride pour un Référencement Durable

Comment faire du référencement naturel intelligent aujourd’hui ? Adopter une méthode hybride pour l’utilisation de l’intelligence artificielle en SEO est essentiel. Cette approche a l’avantage d’être équilibrée. Elle combine, pour optimiser le contenu web, l’efficacité de l’IA, la précision des outils SEO et la perspicacité humaine. Elle répond à l’urgence de développer un marketing de contenu respectueux de l’environnement comme le green seo. Mais elle garantit, en même temps, une efficacité maximale dans le référencement sur des moteurs tels que Google et Bing.

Utilisation de l'IA pour une Analyse Préliminaire

L’utilisation initiale de l’intelligence artificielle dans cette méthode hybride se concentre sur l’analyse préliminaire des données. Dans une approche sensée, cet outil d’IA s’utilise en amont du processus de référencement. Il facilite la recherche de tendances et d’informations. Grâce à son potentiel à large spectre, l’IA favorise la compréhension des comportements des utilisateurs. Ne manquez pas cette opportunité. Insérer cette étape est crucial pour la formulation de stratégies de contenu SEO pertinentes. C’est un moyen efficace d’aligner les objectifs de référencement avec les attentes des utilisateurs, tout en satisfaisant les critères des moteurs de recherche.

Intégration d'Outils SEO Professionnels

La deuxième “couche” de la méthode hybride consiste à intégrer des outils SEO professionnels comme Ahrefs, Ranxplorer, Semrush et Semji. Ces outils, certes payants, sont de formidables appareils. Ils fournissent des informations précises sur les mots clés, les volumes de trafic et d’autres indicateurs essentiels pour le référencement. Leur utilisation permet d’affiner l’optimisation du contenu web. Vos pages auront une meilleure performance et seront alignées avec les réelles intentions de recherche. Vous saurez par exemple choisir entre des requêtes transactionnelles ou informationnelles. Vous pourrez également savoir si le contenu peut être géolocalisé ou si des mots clés longue traîne doivent être travaillés.

Le Rôle Prédominant de l'Humain

Au cœur de cette approche, le rôle de l’humain est prédominant. Son intervention doit être prévue à toutes les étapes du processus de référencement. Simplement, pour que vos contenus soient pertinents et efficaces, c’est l’expert SEO qui doit rester aux manettes. Il doit judicieusement décider quand et comment mobiliser les ressources de l’IA. Par exemple, l’étape de recherche sera dosée à 80/20 : 80 % d’IA et 20 % d’humain. D’une certaine façon, le travail de cette phase est optimisé par l’humain, qui vient ajouter une couche organisationnelle. Le dosage s’effectue différemment au cours des autres étapes du travail de production. Si vous laissez l’IA piloter votre processus, vos contenus ressembleront à tous les autres. Ils seront fades et sans muscles. Le système produira un mélange des données qu’il a rassemblé de façon mathématique autour de votre sujet.

Optimisation du Temps et Enrichissement du Contenu

L’étape finale de cette méthode hybride est de capitaliser sur le temps économisé grâce à l’IA, en parallèle des outils SEO. C’est, d’une certaine façon, le supplément de perfection que l’IA autorise par son travail de fond. Par exemple, les experts en référencement peuvent utiliser ce temps pour enrichir le contenu web par des interviews, des vidéos, ou l’ajout de références bibliographiques. Ces ajouts enrichissent le texte, répondant aux critères de l’EEAT de Google SGE et augmentant ainsi la valeur du contenu pour les utilisateurs et pour les stratégies de marketing de contenu. L’optimisation du temps libéré est essentielle si vous souhaitez que le contenu se démarque de la concurrence.

IA, SEO et loi des rendements décroissants : conclusion

Concluons maintenant cette exploration des relations entre intelligence artificielle et SEO. Mon article était construit autour de la question suivante : la loi des rendements décroissants s’applique-t-elle ? Vous avez voyagé à travers le temps, revisitant l’apparition de la loi des rendements décroissants dans l’économie du 19e siècle. Cette loi, initialement ancrée dans l’agriculture, s’avère étonnamment pertinente dans le contexte moderne du couple intelligence artificielle et SEO.

Mon périple vous a également amené à découvrir les courants de recherche actuels. Ceux-ci visent à développer une IA plus écoresponsable et moins gourmande en énergie. Ces efforts reflètent une conscience grandissante des implications environnementales de cette technologie. C’est même une façon, pour NVIDIA, de travailler l’acceptation sociétale de la technologie IA.

Après mon développement, j’en arrive à la conclusion suivante. La loi des rendements décroissants s’applique à l’intelligence artificielle et au SEO, spécifiquement dans le domaine de la production de contenus rédactionnels. Tout comme un agriculteur prudent sait qu’un excès d’engrais peut nuire à ses cultures, l’usage excessif des outils d’IA en SEO peut altérer la qualité des contenus rédactionnels.

L’analogie taquine entre l’agriculture et le référencement naturel fut le point de départ de ma réflexion. Cette idée ne pouvait émerger que d’un esprit humain. Car, finalement, une touche de « naturel » apportée par l’intelligence humaine est le meilleur engrais pour cultiver une stratégie réussie mêlant intelligence artificielle et SEO.

Vous avez besoin d'aide pour produire vos contenus web ?

Tenir compte des consommations énergétiques des outils d’IA est une nécessité. C’est, de plus, vertueux pour la qualité des contenus. Vous voulez travailler dans cette direction ?